Ключові терміни:

байт, біт, дані, знакові моделі, кількість інформації, повідомлення, підсистема, сигнал, система, системологія, структура, інформатика , інформаціяПоняття інформації

Інформація - це первинне значення, яке не має строгого визначення.

Інформація - це найрізноманітніші відомості, повідомлення, звістки, знання та вміння. Тривалий час інформація здавалася чимось особистим, що належить окремих членам людського роду. Але поступово формувалося переконання, що інформація, відчужена від окремих людей, може мати і суспільне значення.

У широкому, філософському сенсі «інформація» - це відображення реального світу; у вузькому сенсі «інформація »- це будь-які відомості, що є об'єктом зберігання, передачі і перетворення.

Наведемо наступний приклад-задачку(див. Тренажер. Звуковий лист).

При класифікації об'єктів однієї природи в якості бази для класифікації використовують ті чи інші властивості (набір властивостей) об'єктів.

Властивості інформації:

- релевантність - здатність інформації відповідати потребам (запитам) споживача;

- повнота - властивість інформації вичерпно (для даного споживача) характеризувати об'єкт та / або процес, що відображається;

- своєчасність - здатність інформації відповідати потребам споживача в потрібний момент часу;

- достовірність - властивість інформації не мати прихованих помилок;

- доступність - властивість інформації, що характеризує можливість її отримання даним споживачем;

- захищеність - властивість інформації, що характеризує неможливість несанкціонованого використання або зміни;

- ергономічність - властивість, що характеризує зручність форми або обсягу інформації з точки зору споживача.

За способом внутрішньої організації інформацію поділяють на дві групи:

- Дані або простий, логічно невпорядкований набір відомостей.

- Логічно впорядковані, організовані набори даних.

У другій групі можна виділити особливо організовану інформацію - знання.

З поняттям інформації тісно пов'язані такі поняття, як сигнал, повідомлення і дані .

Сигнал (від латинського signum - знак) є будь-який процес, що несе інформацію.

Повідомлення - це інформація, представлена в певній формі та призначена для передачі.

Дані (лат. data) - це інформація, подана у формалізованому вигляді і призначена для обробки технічними засобами, наприклад, ЕОМ.

Розрізняють дві форми подання інформації - безперервну і дискретну.

Оскільки носіями інформації є сигнали, то в якості останніх можуть використовуватися фізичні процеси різної природи. Наприклад, процес протікання електричного струму в ланцюзі, процес механічного переміщення тіла, процес поширення світла тощо. Інформація подається (відображається) значенням одного або декількох параметрів фізичного процесу (сигналу), або комбінацією декількох параметрів.

Сигнал називається безперервним, якщо його параметри в заданих межах можуть приймати будь-які проміжні значення.

Сигнал називається дискретним, якщо його параметри в заданих межах можуть приймати окремі фіксовані значення.

Інформація є первинним і невизначеним поняттям. Воно передбачає наявність матеріального носія інформації, джерела інформації, передавача інформації, приймача і каналу зв'язку між джерелом і приймачем. Поняття інформації використовується в усіх сферах: науці, техніці, культурі, соціології та повсякденному житті.

Поняття кількості інформації

Мірою невизначеності (неповноту знань) в теорії інформації називають ентропією.

Кількість інформації - це числова характеристика сигналу, що відображає ту ступінь невизначеності, яка зникає після отримання повідомлення у вигляді даного сигналу.

Якщо в результаті отримання повідомлення досягається повна ясність в якомусь питанні, говорять, що була отримана повна або вичерпна інформація і необхідності в отриманні додаткової інформації немає. І, навпаки, якщо після отримання повідомлення невизначеність залишилася попередньою, значить, інформації отримано не було (нульова інформація).

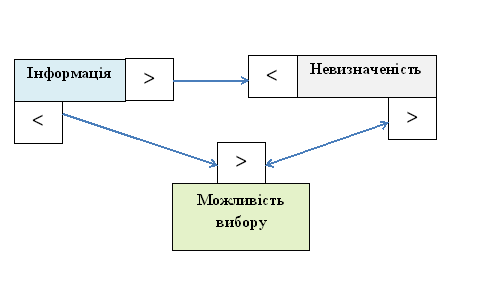

Наведені міркування показують, що між поняттями інформація, невизначеність і можливість вибору існує тісний зв'язок.

Так, будь-яка невизначеність припускає можливість вибору, а будь-яка інформація, зменшуючи невизначеність, зменшує і можливість вибору. При повній інформації вибору немає. Часткова інформація зменшує число варіантів вибору, скорочуючи тим самим невизначеність.

Розглянемо приклад . Людина кидає монету і спостерігає, якою cтopoною вона впаде. Обидві сторони монети рівноправні, тому однаково ймовірно, що випаде одна або інша сторона. Такої ситуації приписується початкова невизначеність, яка характеризується двома можливостями. Після того, як монета впаде, досягається повна ясність, і невизначеність зникає (стає рівною нулю).

Наведений приклад відноситься до групи подій, стосовно яких може бути поставлене питання типу «так-ні».

Кількість інформації, яку можна отримати при відповіді на питання типу «так-ні», називається бітом (англ. bit - скорочене від binary digit - біт).

Біт - мінімальна одиниця кількості інформації, бо отримати інформацію меншу, ніж 1 біт, неможливо. Таким чином, кожне кидання монети дає нам інформацію в 1 біт.

Розглянемо систему з двох електричних лампочок, які незалежно одна від одної можуть бути включені або вимкнені. Для такої системи можливі такі стани:

Лампа А: 0 0 1 1;

Лампа В: 0 1 0 1.

Щоб отримати повну інформацію про стан системи, необхідно задати два питання типу «так-ні» по лампочці А і лампочці В, відповідно. В цьому випадку кількість інформації, що міститься в даній системі, визначається вже в 2 бітa, a число можливих станів системи - 4. Якщо взяти три лампочки, то необхідно задати вже три питання і отримати 3 бітa інформації. Кількість станів такої системи дорівнює 8 і т. Д. Зв'язок між кількістю інформації і числом станів Системи встановлюється формулою Хартлі .

[TEX]i=\log_{2}{N} [/TEX],

де [TEX]i[/TEX] - кількість інформації в бітах;

[TEX]N[/TEX] - число можливих станів.

Ту ж формулу можна представити інакше: [TEX]N=2^i[/TEX].

Група з 8 бітів інформації називається байтом .

Якщо біт - мінімальна одиниця інформації, то байт - її основна одиниця. Існують похідні одиниці інформації: кілобайт (Кбайт, Кб), мегабайт (Мбайт, Мб) і гігабайт (Гбайт, Гб).

Оволодіння інформацією неможливо без появи науки про неї. Інформатика відіграє таку ж фундаментальну роль, як ті науки, які допомогли людству проникнути в таємниці речовини і енергії. Тому інформатику по праву називають царицею наук в інформаційному суспільстві.

Інформатика - це наука, що вивчає всі аспекти отримання, зберігання, перетворення, передачі і використання інформації. Інформатика стала розвиватися з середини 20 століття, коли з'явилися спеціальні пристрої - комп'ютери, орієнтовані на зберігання і перетворення інформації, і сталася комп'ютерна революція.

Принципи фон Неймана

Більшість сучасних ЕОМ будується на базі принципів, сформульованих американським ученим, одним із «батьків» кібернетики Дж. фон Нейманом.

Ці принципи зводяться до наступного:

1. Основними блоками фон-неймановської машини є блок управління, арифметико-логічний пристрій, пам'ять і пристрій введення-виведення.

2. Інформація кодується в двійковій формі і розділяється на одиниці, які називаються словами.

3. Алгоритм представляється у формі послідовності керуючих слів, які визначають сенс операції. Ці керуючі слова називаються командами. Сукупність команд, що представляє алгоритм, називається програмою.

4. Програми і дані зберігаються в одній і тій же пам'яті. Різнотипні слова розрізняються за способом використання, але не за способом кодування.

5. Пристрій керування та арифметичний пристрій зазвичай об'єднуються в один, який називається центральним процесором. Вони визначають дії, які підлягають виконанню, шляхом зчитування команд з оперативної пам'яті. Обробка інформації, яка приписана алгоритмом, зводиться до послідовного виконання команд в порядку, однозначно визначеному програмою.

Сиcтемологія

Системологія — (від -гр. σύστημα — ціле, системне як неподільне, складне як складене з частин; логос (від грец. Λόγος - «слово», «думка», «сенс», «поняття», - як наука), - область науково-практичної діяльності, що вивчає і використовує системність, організацію і самоорганізацію об'єктів, процесів і явищ в природі, науці, техніці, суспільстві і психології особистості, включаючи нову для біофізики (біофізика складних систем) сінергологію.

Основні теоретичні уявлення системології були спочатку розроблені біологами.

З 40-х років розвиток системології з області біології переходить до інших дисциплін -

кібернетики (роботи Н.Вінера, В.А.Котельнікова, К.Шеннона, У.Росс Ешбі, Б.С.Флейшмана і ін.),

термодинамічної хімії (роботи І. Пригожина про виникнення упорядкованих стійких систем далеких від рівноваги),

еволюційної хімії (теорія автокаталізу А.П.Руденко, гіперциклів М.Ейгена),

фізики (лазерне випромінювання, фрактальні структури).

У 70-80 роках відбувається міждисциплінарна взаємодія дослідників самоорганізуючих систем, для яких була організована Біологічна комп'ютерна лабораторія в університеті Урбана (США), і "глобалізація" концепції самоорганізації - використання її для вивчення процесів у найрізноманітніших сферах діяльності: науці, техніці (створення штучного інтелекту), економіці (самоорганізація ринку), соціології, політики.

Тут слід назвати роботи Б.С.Флейшмана (1982), книга якого "Основи системології" містить концептуальні і математичні основи теорії складних систем і в якій демонструються можливості системології у вирішенні актуальних завдань екології та охорони навколишнього природного середовища. Його роботи по праву можна віднести до розряду "конструктивної системної екології".

Особливе значення для розвитку синергетики мали революційні роботи І.Пригожина про поведінку систем в умовах, віддалених від стану рівноваги. Він показав, що на тлі розбалансування та зростання ентропії у відкритих системах можуть виникати нові впорядковані структури, що отримали назву дисипативних, тобто виникаючих в умовах розпаду системи. Ці структури не залежать від початкового стану системи, її передісторії - організація і властивості їх не можуть бути передбачені. Дисипативні структури досягають рівноважного стану, відповідно новим умовам. Поява дисипативних структур змінює вектор розвитку (при цьому вихідні системи можуть зберігатися внаслідок гетерогенності середовища в просторі). Ці точки біфуркації відповідають раніше постульованим еволюціоністами принципу дихотомії, який лежить в основі всіх еволюційних побудов в біології.

Відповідно до цих поглядів змінилося і саме поняття "самоорганізація". Уявлення про самоорганізацію стосовно кібернетики були розвинені в 1947 р. роботі У.Росс Ешбі "Принципи самоорганізуючої динамічної системи". У ній самоорганізація визначалася як здатність систем спонтанно змінювати свою структуру в залежності від досвіду і навколишнього середовища. Основою самоорганізації є механізм самонавчання; моделлю якого було становлення нервової системи в онтогенезі. Такі системи, самоорганізація яких заснована на властивих їм внутрішніх механізмах управління, отримали назву класичних.

У 60-х роках в кібернетиці виникає інше розуміння самоорганізації, засноване на запропонованому Г.фон Фёстером (1964) принципі "порядок з шуму", яке отримало назву "некласичної концепції самоорганізації". Воно засноване на циклічних процесах, породжуваних в живих організмах у відповідь на випадкові події. Така самоорганізація не пов'язана з наявністю внутрішнього керуючого органу, а здійснюється за рахунок безпосередньої локальної взаємодії компонентів системи. Вони є результатом "... здібності фізіологічних процесів організовуватися в певну синергетичну діяльність" (Вінер, 1969). При цьому напрямок (мета) розвитку не задається керуючими органами, а "вибирається" самою системою.

Один з основних системологічних висновків полягає в тому, що весь оточуючий нас світ складається з взаємопов'язаних в тій чи іншій мірі систем, що володіють певним ступенем стійкості.

Наприклад, атом - стійке утворення, складається з ядра і електронів. На його основі формуються молекули, з молекул формуються різні види речовин. Атом є підсистемою молекули, які в свою чергу є підсистемами більш великих матеріальних утворень. Матеріальні утворення в свою чергу утворюють ієрархію підсистем.

Таким чином, одним з основних понять системології є система, під якою розуміється стійке матеріальне утворення, що володіє деяким компонентним (елементних), складом і структурою.

Структура - це стійкі взаємозв'язки або взаємодії між елементами системи.

Підсистема - це система, яка розглядається як неподільний компонент системи вищого рівня.

Між підсистемою і системою існують взаємозв'язки, які й призводять до формування з підсистем системи.

У наведеному вище прикладі електричні сили взаємодії електронів і ядра призводять до утворення підсистем - молекул, а молекулярні сили взаємодії між молекулами призводять до формування систем - різних речовин, які в свою чергу є підсистемами інших систем - більш складних матеріальних утворень. Більш складні види взаємодії здійснюються на інших рівнях ієрархії систем.

Наприклад, побудова інформаційних систем здійснюється на основі інформаційних взаємозв'язків між її компонентами.

Найбільш значущі роботи узагальнюючого плану зроблено в останньому періоді виходячи з прототипу системи:

-

Богданов А.А, — досліджуючи природні та соціальні системи і саму організацію науки, як творчий вид діяльності;

-

Анохін П. К., — досліджуючи формування природних систем у вищій нервовій діяльності сформував прототип та ввів важливе базисне поняття системогенезу;

Роботи багатьох авторів близькі до історії формування системології, але складають пошуковий характер як за поняттями, так і відносне наближення підходів:

-

Л. Барталанфи - системний світогляд;

-

О. Лангре - система та целе;

-

У. Росс Эшби - складні системи, великі системи;

-

М. Аккоф - системний підхід;

-

И. Клір - системна методологія, а перекладацька школа видавництва ;

-

Г. Хакен - синергетика;

-

М. Месарович - системна ідеологія, загальна теорія систем;

-

Н. Бусленко - моделювання систем;

-

М. Месарович, М. Бусленко - теорія складних систем;

-

И. Пригожин - теорія самоорганізації;

-

А.И.Уйомов, Ю.А.Урманцев – загальна теорія систем;

-

А.О. Рум'янцев, А.А. Гагаєв – субстратний підхід;

-

А.Н. Малюта - інвариантне моделювання.

Матеріальні і знакові системи. Програмні системи як різновид знакових

Системи діляться на:

- матеріальні і

- знакові.

Останні, в тій чи іншій мірі відображають перші, називаються їх знаковими моделями.

Наші уявлення про матеріальні утвореннях є знаковими моделями, або знаковими системами, які в свою чергу утворюють ієрархію підсистем.

В даний час програмне забезпечення моделює окремі функціональні можливості як матеріальних, так і знакових систем, і в цьому сенсі є знаковою моделлю, або знаковою системою. Якщо інтелектуальна діяльність мозку є знаковою моделлю матеріальної освіти, то програмне забезпечення є знаковою системою інтелектуальної діяльності, подання матеріальних і (або) знакових систем.

Методологія об'єктно-орієнтованого аналізу і проектування програмного забезпечення як різновид реалізації системного підходу успішно застосовується для створення складних програмних систем, які можна віднести до знакових. Основні системологічні принципи поширюються на створення програмних систем і на їх методологію.(к.т.н. И.М. Слюсаренко, к.т.н. М.Ю Слюсаренко "Системологический подход к декомпозиции в объектно-ориентированном анализе и проектировании программного обеспечения" - http://citforum.ru/programming/case/ooad_systemology/)

Якщо деякі елементи об'єднати в систему, то вона володітиме новими якостями, якими не володіли її складові частини.

Поява нової якості у системи називається системним ефектом. Це ж властивість виражається фразою:

«Ціле більше суми своїх частин».

Про системи і підсистеми. В якості ще одного прикладу системи розглянемо об'єкт - персональний комп'ютер (ПК).

Саме поверхневий опис ПК такий: це система, елементами якої є системний блок, клавіатура, монітор, принтер, миша.

Чи можна назвати їх простими елементами?

Звичайно, ні! Кожна з цих частин - це теж система, що складається з безлічі взаємозалежних елементів.

З базового курсу інформатики відомо, що до складу системного блоку входять: центральний процесор, оперативна пам'ять, накопичувачі на жорстких і гнучких магнітних дисках, СD-RОМ, контролери зовнішніх пристроїв та ін. В свою чергу, кожний з цих пристроїв - складна система.

Наприклад, центральний процесор складається з арифметико-логічного пристрою, пристрою управління, регістрів. Так можна продовжувати і далі, все більш заглиблюючись у подробиці пристрою комп'ютера.

Також підсистемою називають систему, що входить до складу якоїсь іншої, більш великої системи.

З даного визначення випливає, що системний блок є підсистемою персонального комп'ютера, а процесор - підсистемою системного блоку.

Будь-який реальний об'єкт нескінченно складний. Опис його складу і структури завжди носить модельний характер, тобто є наближеним. Ступінь детальності такого опису залежить від його призначення. Одна і та ж частина системи в одних випадках може розглядатися як її простий елемент, в інших - як підсистема, що має свій склад і структуру.

Про системи в науці та системний підхід.

Основний сенс дослідницької роботи вченого найчастіше полягає в пошуку системи в предметі його дослідження. Задача науки - знайти системні закономірності в тих об'єктах і процесах, які вона вивчає.

Історія комп'ютерної техніки

Як був винайдений комп'ютер.

Слово «комп'ютер» означає «обчислювач», тобто пристрій для обчислень. Потреба в автоматизації обробки даних, в тому числі обчислень, виникла дуже давно - відразу ж, як тільки люди стали продавати і купувати товари. Багато тисяч років тому для рахунки використовувалися лічильні палички, камінчики і т.д. Однин з перших пристроїв - абак (схожий на рахівницю) було створено близько п'яти тисяч років тому у Вавилоні (на території нинішніх Ірану та Іраку).

Спеціальні числа.

У 1614 р шотландський математик Джон Непер (1550-1617) винайшов таблиці логарифмів . Принцип їх полягає в тому, що кожному числу відповідає своє спеціальне число - логарифм. Логарифми дуже спрощують поділ і множення. Наприклад, для множення двох чисел досить скласти їх логарифми. Результат знаходять в таблиці логарифмів.

Старовинний калькулятор.

У 1642 р. французький математик Блез Паскаль (1623-1662) сконструював рахунковий пристрій, щоб полегшити працю свого батька - податкового інспектора, якому доводилося робити чимало складних обчислень. Цей пристрій був змонтований в дерев'яному корпусі як система зубчастих коліс, що обертали диски з цифрами. Результат обчислень зчитувався в спеціально прорізаних в корпусі віконечках. Вірячи, що цей винахід принесе удачу, батько з сином вклали у створення свого пристрою великі гроші. Але проти рахункового пристрою Паскаля виступили клерки - вони побоювалися втратити через нього роботу, а також роботодавці, які вважали, що краще найняти дешевих рахівників, ніж купувати дорогу машину.

У 1673 р. Готфрід Вільгельм Лейбніц сконструював арифмометр, дозволяє механічно виконувати чотири арифметичні дії. Починаючи з XIX в. арифмометри отримали дуже широке застосування. На них виконували навіть дуже складні розрахунки, наприклад розрахунки балістичних таблиць для артилерійських стрільб. Існувала і спеціальна професія - лічильник - людина, що працює з арифмометром, швидко і точно дотримується певну послідовність інструкцій (таку послідовність інструкцій згодом стали називати програмою). Але багато розрахунки проводилися дуже повільно - навіть десятки лічильників повинні були працювати по кілька тижнів і місяців. Причина проста - при таких розрахунках вибір виконуваних дій і запис результатів вироблялися людиною, а швидкість його роботи дуже обмежена.

У 1833 р. англійський математик Чарльз Беббідж детально розробив проект аналітичної машини ("обчислювального помічника"). Чарльз Беббідж (1792-1871) був сином багатого банкіра з Девона (Англія) і дуже талановитим математиком. Він виявив похибки в таблицях логарифмів Непера і в 1821 р. розпочав розробку своєї обчислювальної машини. Це був складний, великий пристрій. Він призначався для автоматичного обчислення логарифмів. Особливо важко, виявилося, досягати точних розрахунків. Британський уряд десять років фінансував роботи Беббіджа, але потім втратив до нього довіру і припинив давати гроші. Наступною роботою Беббіджа якраз і стало створення аналітичної машини, яка повинна була стати першою універсальною обчислювальною машиною, що виконує обчислення без участі людини. Для цього вона повинна була вміти виконувати програми, що вводяться за допомогою перфокарт (карт з щільного паперу з інформацією, що відтворюється за допомогою отворів -перфокарти вже широко вживалися в ткацьких верстатах), а також мати «склад» для запам'ятовування даних і проміжних результатів (в сучасній термінології - пам'ять). Беббіджу допомагала математик Ада Ловлас (1815-1852) - перший програміст-леді. Вона створила для машини кілька програм, які зберігалися на спеціальних перфокартах. Останні 37 років життя Беббідж присвятив удосконаленню аналітичної машини. Він вкладав в її створення великі гроші і важко переносив повна відсутність інтересу з боку громадськості до своїх робіт. Помер Беббіджв 1871 р., так і не закінчивши свою працю. Його машина набагато випереджала технічні можливості свого часу, і довести її створення до кінця було практично неможливо, проте він розробив всі основні ідеї.

В XIX ст. в США перепис населення проводився кожні 10 років. З ростом населення це стало вельми складним процесом. Так, в 1887 р. чиновники все ще підводили підсумки перепису 1880. Багато уваги приділялось методам швидшого підрахунку підсумків. Перемогу в цьому змаганні здобув інженер Герман Холлерит (1860 - 1929). Він створив електричну рахункову машину - табулятор. Дані про кожного жителя зберігалися на персональній перфокарті. Розташування і число отворів відповідало таким відомостями, як вік, сімейний стан тощо. Карта вставлялася в машину, де на неї натискали кінці проводів. Коли провід потрапляв в отвір, замикався єлектричний контакт і лічильник пересувався на одну поділку. Винахід Холлерита настільки прискорив методи обробки даних, що підсумки перепису 1890 були підведені всього через 6 тижнів

Електронні рахункові машини

У 1937 р. Алан Тьюрінг запропонував універсальну схему обчислень. Його результати були сформульовані в термінах гіпотетичної "машини" з простою структурою, яка володіла всіма необхідними ознаками універсальної обчислювальної машини.

У 1943 р американець Говард Ейкен за допомогою робіт Беббіджа на основі техніки XX в. - електромеханічних реле - зміг побудувати на одному з підприємств фірми IBM (International Business Machine corp.) обчислювальну машину під назвою «Марк-1» . Ще раніше ідеї Беббіджа були використані німецьким інженером Конрадом Цузе , який у 1941 р. побудував аналогічну машину.

У 1946 р Джон П. Екерт і Джон В. Моглі (1907-1980) розробили один з перших комп'ютерів для армії США- ENIAC(електронний числовий інтегратор і калькулятор) на електронних лампах. У порівнянні з сучасними ЕОМ він був дуже громіздкий - обіймав цілий зал і при цьому виконував набагато менше операцій. ENIAC працював в 1000 разів швидше ніж «Марк-1», однак, для завдання програми доводилося протягом декількох годин або навіть днів приєднувати потрібним чином проводи. Щоб спростити цей процес, Моглі і Екерт стали конструювати ЕОМ, яка могла б зберігати програму у своїй пам'яті.

У 1945 р. до роботи Моглі і Екерта був залучений знаменитий математик Джон фон Нейман, який підготував доповідь про цю машину. Доповідь була розіслана багатьом вченим і отримав широку популярність, оскільки в ньому фон Нейман ясно і просто сформулював загальні принципи функціонування універсальних обчислювальних пристроїв, тобто комп'ютерів.

У 1949. р англійським дослідником Морісом Уілксом був побудований перший комп'ютер, в якому були втілені принципи фон Неймана.

Технологія ЕОМ поступово вдосконалювалася, габарити комп'ютерів зменшувалися, а їх можливості збільшувалися. На перших комп'ютерах застосовувалися електронні лампи. В 1948 р. їх замінили транзистори, які винайшли троє американських учених - Джон Бардін, Уолтер Браттейн (1902-1987) і Вільям Шоклі (1910-1989). За свій винахід вони отримали в 1956 р. Нобелівську премію з фізики. В наші дні компактні калькулятори і комп'ютери використовують мікросхеми, що складаються з багатьох тисяч транзисторів. Вони стали набагато більш потужними, але переважна більшість з них зроблено у відповідності з тими принципами, які виклав у своїй доповіді в 1945 р. Джон фон Нейман.